반응형

Basic Information

- Junxian He, Chunting Zhou, Xuezhe Ma, Taylor Berg-Kirkpatrick, Graham Neubig 저

- 2021.10.08. (1차) / 2022.02.02. (3차)

- ICLR 등재

- 논문 아카이브: Link

서론

- transfer learning과 parameter-efficient transfer learning에 대한 개념과 중요성을 소개합니다. 논문에서는 transfer learning을 일반적으로 더 큰 데이터셋에서 학습된 모델을 작은 데이터셋에서 적용하는 것으로 정의하며, 이를 통해 작은 데이터셋에서도 높은 성능을 얻을 수 있다고 강조합니다. 하지만 모델의 파라미터 수가 많을수록 transfer learning의 성능이 떨어지는 것이 문제점으로 지적합니다.

- 이를 해결하기 위해 parameter-efficient transfer learning을 소개하며, 이는 더 적은 파라미터 수를 가지는 모델로도 transfer learning을 수행할 수 있도록 합니다.

- 또한 parameter-efficient transfer learning의 중요성과 관련 선행 연구들에 대해 언급합니다. 예를 들어, 논문에서는 weight pruning, quantization, distillation, knowledge distillation, model compression 등의 기술들이 parameter-efficient transfer learning에 적용되는 방법에 대해 소개합니다.

연구 목표

- Transfer learning과 parameter-efficient transfer learning의 차이점을 분석하고, parameter-efficient transfer learning을 위한 기술들을 조사하며, 이를 통해 parameter-efficient transfer learning이 transfer learning보다 더 효과적인 이유를 분석하는 것입니다.

- 또한, 논문에서는 이러한 분석을 토대로 더욱 효율적인 전이 학습을 위한 방향성을 제시합니다.

연구 방법

- 논문에서는 transfer learning과 parameter-efficient transfer learning의 차이점을 설명하며, 각각의 기술적 특징을 비교합니다. 이를 토대로 parameter-efficient transfer learning의 중요성을 강조하고, parameter-efficient transfer learning을 위한 다양한 기술들을 소개합니다.

- 또한, 논문에서는 parameter-efficient transfer learning의 효과를 검증하기 위해 실험을 수행합니다.

- 실험에서는 다양한 데이터셋과 모델을 사용하여 parameter-efficient transfer learning을 적용한 결과를 비교합니다.

- 논문에서는 parameter-efficient transfer learning을 적용하기 전과 후의 모델의 파라미터 수와 정확도를 비교하여 parameter-efficient transfer learning의 효과를 측정합니다.

- 논문에서는 또한 parameter-efficient transfer learning을 적용하는 방법에 대한 가이드라인도 제시합니다. 이 가이드라인은 모델의 파라미터 수를 줄이면서도 모델의 성능을 유지할 수 있도록 도와줍니다. 이를 통해 논문은 parameter-efficient transfer learning을 더욱 효과적으로 수행할 수 있도록 지침을 제공합니다.

Overall

Adapters

h ← h + f(hWdown)Wup.

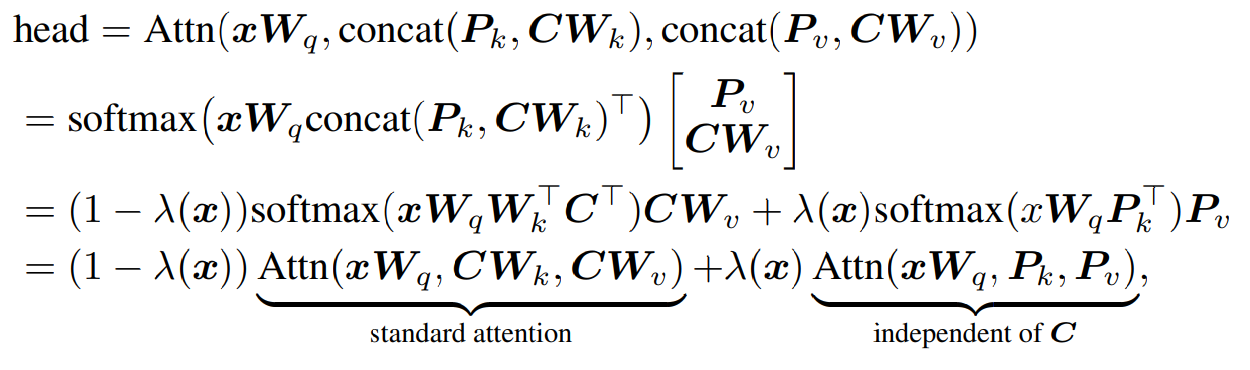

Prefix Tuning

headi=Attn(xW(i)q,concat(P(i)k,CW(i)k),concat(P(i)v,CW(i)v)),

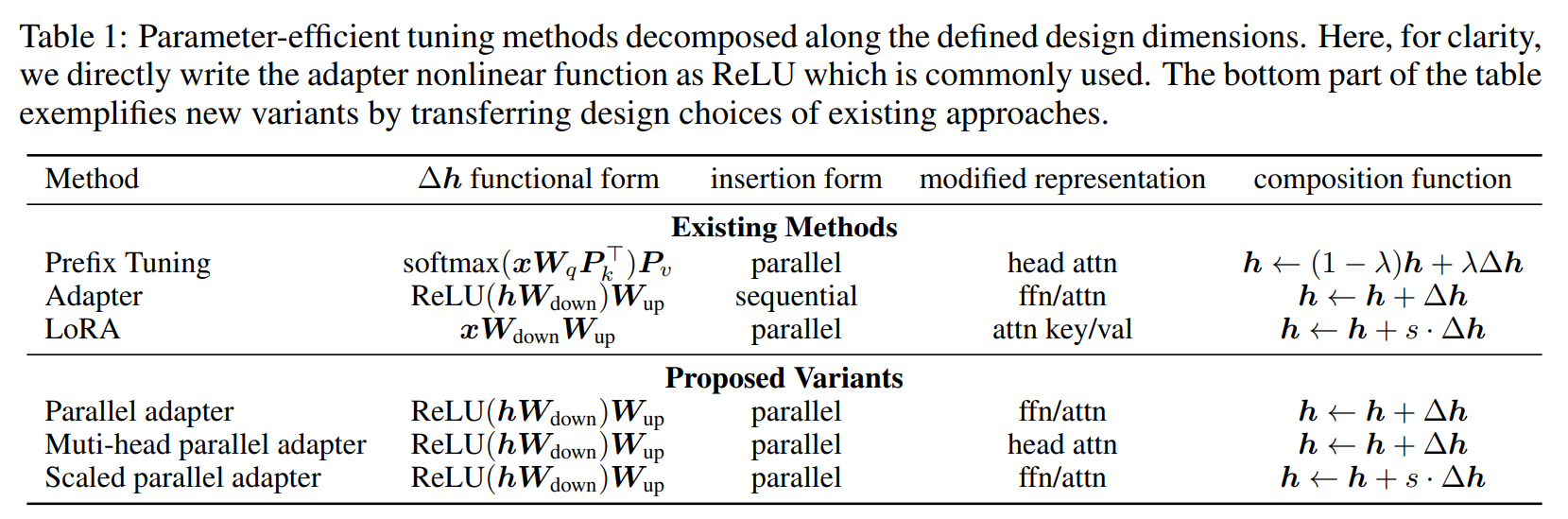

Parameter-efficient Tuning Methods Table

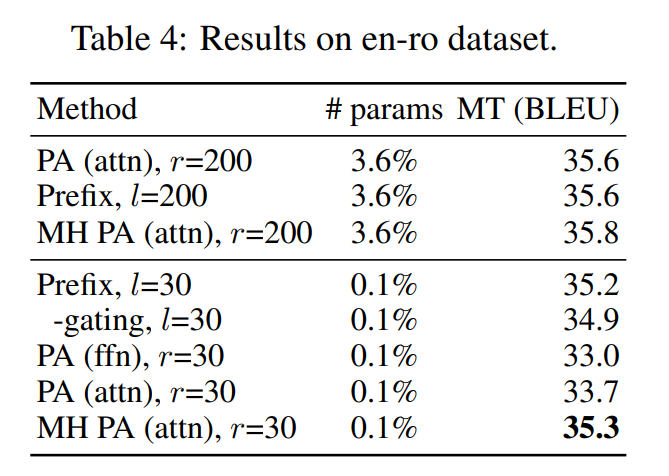

실험 결과

- 실험 결과에서는 parameter-efficient transfer learning을 적용한 결과를 보여줍니다. 실험에서는 다양한 데이터셋과 모델을 사용하여 parameter-efficient transfer learning을 적용한 결과를 비교합니다. 논문에서는 parameter-efficient transfer learning을 적용하기 전과 후의 모델의 파라미터 수와 정확도를 비교하여 parameter-efficient transfer learning의 효과를 측정합니다.

- Parameter-efficient transfer learning을 적용했을 때 모델의 파라미터 수가 줄어들었음에도 불구하고 모델의 정확도가 유지되거나 향상되는 것을 확인할 수 있습니다. 논문에서는 이러한 결과를 통해 parameter-efficient transfer learning이 transfer learning보다 더 효과적인 이유를 분석합니다.

결론

- parameter-efficient transfer learning이 transfer learning보다 더 효과적인 이유를 강조하며, 더욱 효율적인 전이 학습을 위한 방향성을 제시합니다.

- 논문에서는 parameter-efficient transfer learning을 적용했을 때, 모델의 파라미터 수가 줄어들어도 모델의 정확도가 유지되거나 향상되는 것을 실험을 통해 확인했습니다. 이러한 결과는 parameter-efficient transfer learning이 작은 수의 파라미터로도 효과적인 학습을 수행할 수 있다는 것을 보여줍니다.

- 결론에서는 또한 parameter-efficient transfer learning을 위한 다양한 기술들을 소개하며, 이들을 조합하여 더욱 효율적인 전이 학습을 수행할 수 있다는 것을 강조합니다. 예를 들어, weight pruning, quantization, distillation, knowledge distillation, model compression 등의 기술들을 사용하여 모델의 파라미터 수를 줄일 수 있으며, 이를 통해 더욱 효율적인 전이 학습을 수행할 수 있습니다.

- 또한, 논문에서는 parameter-efficient transfer learning을 적용하는 방법에 대한 가이드라인을 제공합니다. 이 가이드라인은 모델의 파라미터 수를 줄이면서도 모델의 성능을 유지할 수 있도록 도와주며, 이를 통해 더욱 효율적인 전이 학습을 수행할 수 있도록 도움을 줍니다.

- 총론적으로, "Towards a Unified View of Parameter-Efficient Transfer Learning"은 parameter-efficient transfer learning의 중요성을 강조하고, 더욱 효율적인 전이 학습을 위한 다양한 방법과 가이드라인을 제공하는 논문입니다. 이러한 연구는 모델의 학습을 더욱 효과적으로 수행할 수 있도록 도움을 줄 것입니다.

반응형