반응형

Basic Information

- Max Zimmer, Christoph Spiegel, Sebastian Pokutta 저

- ICLR 2023 poster

- 비고: 여러 논문들을 종합하며 개념적이며 원리적인 Pruning 최적법을 도출해내는 Rethinking 계열 논문으로, 그 의미를 최대한 담기 위해 내용을 많이 가져왔습니다.

- 논문 아카이브: Link

- Official Github: Link

서론

- 신경망 가지치기(neural network pruning) 방법들은 여러 반복적인 훈련 및 가지치기 단계로 구성되어 있습니다. 이러한 방법들은 가지치기 후에 상당한 성능을 잃어버리는 경향이 있지만, 재훈련 단계에서 이를 회복합니다.

- 최근의 연구들은 재훈련 단계에서 학습률 일정의 중요성을 보여주며, IMP (Han et al., 2015)에 대한 특정 휴리스틱을 제안합니다.

- 이 연구에서는 간단한 선형 학습률 일정을 사용하여 재훈련 단계를 크게 단축할 수 있다는 것을 보여줍니다.

- 또한, 초기 밀도 있는 훈련 단계에 예산을 부여하는 것을 제안하며, 이러한 방법이 훈련 중에 네트워크를 희소화하려는 복잡하거나 많은 매개변수를 가진 최신 기술보다 더 우수한 성능을 내는 것을 보여줍니다.

- 현대의 신경망 구조는 과도하게 많은 매개변수를 가지고 있습니다. 이로 인해 높은 메모리 요구 사항과 계산적으로 복잡하며 긴 훈련 및 추론 시간이 필요합니다.

- 그러나 현대 구조는 가지치기를 통해 크게 압축될 수 있으며, 결과적으로 희소한 모델은 밀도 있는 모델에 비해 저장소와 부동 소수점 연산(FLOPs)이 훨씬 적게 필요합니다.

연구 방법

Major Contribution

- 우리는 Li et al. (2020)의 신경망의 예산화된 훈련(Budgeted Training of Neural Networks)에 관한 결과가 IMP의 재훈련 단계에 적용됨을 경험적으로 발견하였습니다. 이를 통해 Renda et al. (2020) 및 Le & Hua (2021)의 결과에 대한 추가적인 맥락을 제공합니다. 이를 기반으로, 간단한 선형 학습률 일정을 사용함으로써 IMP의 실행 시간을 크게 단축시킬 수 있으며, 모델 성능의 저하가 거의 없거나 전혀 없음을 발견하였습니다.

- 이 선형 일정의 초기 값을 추가적인 하이퍼파라미터 조정 없이 선택하는 새로운 방법을 제안합니다. 이 방법은 ADAPTIVE LINEAR LEARNING RATE RESTARTING (ALLR)의 형태로, 우리의 접근법은 가지치기의 영향과 전반적인 재훈련 시간을 고려하여 다양한 학습 작업에서 이전에 제안된 재훈련 일정을 개선합니다.

- Initial Dense Training 단계를 동일한 예산화된 훈련 체계의 일부로 간주함으로써, 우리는 BUDGETED IMP (BIMP)의 형태로 간단하면서도 효과적인 방법을 도출하였습니다. 이 방법은 네트워크를 처음부터 훈련시키기 위한 동일한 반복 횟수를 주어 많은 Pruning-Stable Algorithm들을 능가할 수 있습니다.

Rethinking Retraining as Budgeted Training

- Han et al. (2015)의 원래 접근법은 FINE TUNING (FT)로 일반적으로 알려져 있습니다:

- T epochs 동안 학습률 일정 (λt)t≤T를 사용하여 훈련하고 가지치기-재훈련 주기당 Trt 에포크를 재훈련한다면, FT는 원래 훈련 중 사용된 마지막 학습률인 λT를 사용하여 가지치기된 네트워크를 재훈련합니다.

- Renda et al. (2020)는 재훈련 중 학습률 일정이 가지치기된 네트워크의 예측 성능에 큰 영향을 미칠 수 있음을 지적하고, 각 주기 동안 마지막 T-Trt 학습률 λT-Trt+1; ... ; λT를 사용하여 가지치기된 네트워크를 Trt 에포크 동안 재훈련하는 LEARNING RATE REWINDING (LRW)를 제안합니다.

- Le & Hua (2021)는 SCALED LEARNING RATE RESTARTING (SLR)을 제안하여 이러한 결과를 더욱 개선하였습니다.

- 여기서 가지치기된 네트워크는 비례적으로 동일한 일정을 사용하여 재훈련되며, 짧은 웜업 단계를 포함하여 (λt)t≤T를 Trt 에포크의 재훈련 시간 프레임으로 압축합니다.

- 또한 Smith & Topin (2017)의 1-cycle 학습률 일정을 기반으로 CYCLIC LEARNING RATE RESTARTING (CLR)을 도입하였습니다.

- 여기서 원래 일정(일반적으로 단계별 일정)은 동일한 초기 학습률 λ1에서 시작하는 코사인 기반의 일정으로 대체되며, 마찬가지로 짧은 웜업 단계를 포함합니다. Figure 1은 60 epochs의 재훈련 예산에 대한 위에서 언급한 일정을 나타냅니다.

- LRW는 WEIGHT REWINDING (WR) (Frankle et al., 2019)의 변형으로 제안되었으며, 그 성공이 Lottery Ticket 가설과 어떤 연결이 있음을 제안합니다.

- Le & Hua (2021)는 SLR을 도입할 때 이미 "큰 학습률의 사용"이라는 주요 특징을 강조하여 더 탄탄한 동기를 제시하였습니다.

- Smith & Topin (2017)의 1-cycle 학습률 일정을 통해 CLR을 제안하고 동기를 부여함으로써, 원래 훈련 중 사용된 rate를 기반으로 학습률 일정을 설정하는 것에 특별한 중요성이 없음을 이미 보여주었습니다.

- 우리는 Li et al. (2020)의 고정된 반복 예산 내에서 신경망 훈련에 관한 결과가 이러한 방법들에 의해 달성된 다양한 성공에 대한 일부 관련 추가 context를 제공하며, 특히 재훈련이 원래 훈련보다 훨씬 짧다고 가정할 때 어떻게 그것들을 더 개선할 수 있는지에 대한 지시사항을 제공한다고 생각합니다. 즉, Trt < T일 때입니다.

- Li et al. (2020)는 네트워크가 훈련될 고정된 epochs 또는 반복 횟수의 형태로 주어진 리소스 예산에서 훈련을 연구합니다. 대신에 일반적인 가정인 어떤 만족스러운 정도로 수렴이 이루어질 때까지 훈련이 실행된다는 것을 따르지 않습니다. 구체적으로, 그들은 주어진 예산 내에서 최대한 높은 성능을 달성하기 위해 어떤 학습률 일정이 가장 적합한지 경험적으로 결정합니다. 그들의 결과에서 두 가지 주요한 결론은 다음과 같습니다:

- 특정 예산 내에서 주어진 학습률 일정을 압축하는 것은 예산이 도달하면 그것을 단순히 잘라내는 것보다 훨씬 뛰어납니다. Li et al. (2020)는 이러한 압축을 BUDGET-AWARE CONVERSION (BAC)으로 참조합니다. 이것은 명확하게 Le & Hua (2021)의 결과와 일치하며, SLR이 LRW보다 우수하다는 것을 보여줍니다. 왜냐하면 SLR은 원래 훈련 일정의 BAC이고 LRW는 그것의 잘린 버전이기 때문입니다(비록 '뒤에서' 잘린 것이지만 앞에서가 아닌).

- 특정 학습률 일정은 다른 것보다 더 넓은 예산 범위에 더 적합합니다. 특히, 그들의 결과는 타이트한 예산이 주어질 때 선형 일정이 최고의 성능을 보이며, 코사인 기반 접근법이 바로 뒤를 따르는 것을 나타냅니다. 이것은 원래 학습률 일정이 더 전통적인 권장 사항을 따를 때 CLR이 SLR보다 우수하다는 것에 대한 설명을 제공합니다.우리는 Li et al. (2020)의 고정된 반복 예산 내에서 신경망 훈련에 관한 결과가 이러한 방법들에 의해 달성된 다양한 성공에 대한 일부 관련 추가 맥락을 제공하며, 특히 재훈련이 원래 훈련보다 훨씬 짧다고 가정할 때 어떻게 그것들을 더 개선할 수 있는지에 대한 지시사항을 제공한다고 생각합니다. 즉, Trt < T일 때입니다. Li et al. (2020)는 네트워크가 훈련될 고정된 에포크 또는 반복 횟수의 형태로 주어진 리소스 예산에서 훈련을 연구합니다. 대신에 일반적인 가정인 어떤 만족스러운 정도로 수렴이 이루어질 때까지 훈련이 실행된다는 것을 따르지 않습니다. 구체적으로, 그들은 주어진 예산 내에서 최대한 높은 성능을 달성하기 위해 어떤 학습률 일정이 가장 적합한지 경험적으로 결정합니다. 그들의 결과에서 두 가지 주요한 결론은 다음과 같습니다:

- 간결하게 말하면, Li et al. (2020)의 예산화된 훈련 맥락에서의 학습률 일정에 관한 경험적 결과는 가지치기 맥락에서의 재훈련 일정의 개발과 개선과 밀접하게 닮아 있습니다. 따라서 우리는 재훈련을 먼저 예산화된 훈련의 관점에서 고려해야 하며, 후자 설정에서 도출된 교훈은 이 맥락에서 일반적으로 적용 가능하다고 주장합니다.

Pruning Stability: Trying to Avoid Retraining

- Pruning-Stable Algorithm들은 최종 '하드' 가지치기 단계에서 정확도가 거의 떨어지지 않고 재훈련 단계가 불필요하게 되도록 초기 밀도 높은 모델에서 잘 수행되는 가지치기 모델을 찾기 위해 정의됩니다.

- 이들은 점진적인 가지치기, 즉 가지치기 마스크를 동적으로 확장하거나 규제 및 제약 최적화 기술을 사용하여 훈련 중 거의 희소한 구조를 학습함으로써 강한 암시적 편향을 유도합니다.

- 많은 방법들도 이를 위해 '소프트' 가지치기에 의존합니다.

- 예를 들면 가중치를 제로화하거나 강력하게 0으로 밀어넣지만 훈련 중 네트워크 아키텍처에서 완전히 제거하지 않습니다.

- 지난 몇 년 동안 이 카테고리에서 제안된 다양한 방법을 간략하게 요약하겠습니다:

- LC와 GSM은 가중치 감쇠의 수정을 사용하며, 가장 작은 점수를 가진 k 가중치를 더 빠르게 0으로 밀어넣습니다.

- DNW는 전진 패스에서 가장 작은 k 가중치를 제로화하면서 밀도 있는 기울기를 계속 사용합니다.

- CS, STR, DST는 모두 추가적으로 훈련 가능한 임계값 매개변수의 생성에 의존하며, 이 매개변수들은 모델을 희소화하는 데 사용되며 일반적인 가중치와 함께 꾸준히 훈련됩니다.

- GMP는 가지치기 마스크를 동적으로 확장하고 업데이트하여 네트워크를 훈련 중에 희소화하는 조절 가능한 가지치기 일정을 따릅니다.

- 마지막으로, 이 아이디어를 기반으로 DPF는 Zhu & Gupta (2017)의 가지치기 일정을 사용하여 가지치기 마스크를 유지하지만, 밀도 있는 매개변수를 업데이트할 때 가지치기된 모델의 (확률적) 기울기를 사용하여 오류 보상을 허용합니다.

- Pruning-Stable Algorithm들과 IMP와 비교했을 때 가장 일반적으로 주장되는 두 가지 장점은 다음과 같습니다:

- 그들은 비싼 반복적인 가지치기-재훈련 주기를 피하기 때문에 초기부터 가지치기된 모델을 더 빠르게 만듭니다.

- '하드' 가지치기를 피하거나 특정 암시적 편향을 사용하기 때문에 선호되는 결과를 생성합니다.

- 많은 이전에 나열된 방법들이 잘 수행되고 최첨단 결과를 달성하고 있지만, 가지치기 안정성의 주장된 장점이 실제로 달성되었다는 실증적 증거는 아직 제공되지 않았습니다.

- 이를 검증하기 위해, 우리는 BUDGETED IMP (BIMP)를 제안합니다.

- 이 방법은 주어진 예산 T 내에서 무작위 초기화로부터 가지치기된 모델을 얻을 수 있으면서도 IMP의 모든 주요 특성을 유지합니다.

- 마지막으로, 어떤 가중치를 가지치기할지 선택하는 방법에 대한 주목할 만한 양이 있었습니다.

- 현재 값의 크기에 따라 가중치를 순위 지정하는 것이 선택의 접근법으로 자리 잡았습니다.

- 우리는 이러한 결과 중 일부를 확인했으며, BIMP에 대해 Han et al. (2015)에 의해 사용된 간단한 전역 선택 기준을 따르겠습니다.

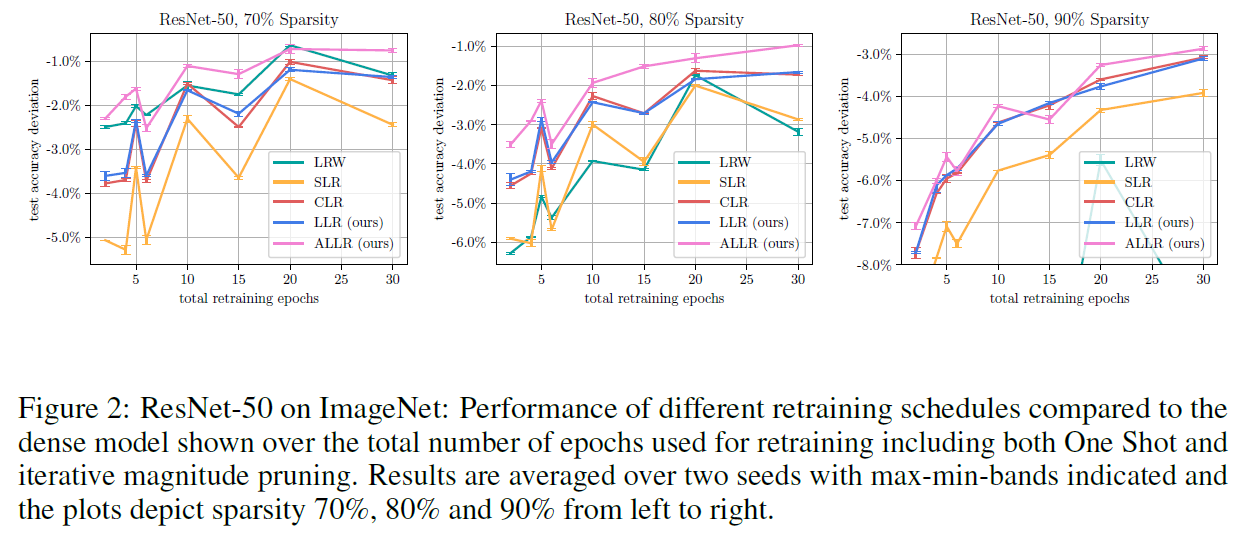

Experimental Results

결론

- BIMP의 경우, 우리는 ALLR을 사용하고 초기 훈련 길이 T0 및 가지치기-재훈련 주기의 수를 하이퍼파라미터로 취급하며, 전체 에포크 예산 T가 초과되지 않도록 하였습니다.

- Pruning-Stable Algorithm들의 각 하이퍼파라미터는 수동으로 정의된 그리드 검색을 사용하여 조정되었으며, 가능한 경우 원래의 출판물의 권장사항을 참조하였습니다.

- Table 2는 CIFAR-10과 ImageNet에 대한 모든 방법의 최종 테스트 성능, 이론적인 가속도 및 실제로 달성된 희소성을 보여줍니다.

- 결과는 BIMP가 여기에서 고려된 많은 Pruning-Stable Algorithm들을 능가할 수 있음을 보여줍니다.

- ImageNet의 경우, DNW는 훈련에 대략 두 배의 시간이 필요한 가격으로 BIMP와 동등하게 또는 더 나은 성능을 지속적으로 보여줍니다.

- 놀랍게도, 넓은 하이퍼파라미터 그리드 검색에도 불구하고, 대부분의 방법들은 BIMP와 비교하여 불리한 것으로 보입니다.

- DPF는 효율적이면서도 강력한 경쟁자입니다.

- BIMP는 동일한 전체 훈련 에포크 수 내에서 이러한 결과를 얻으며, 우리는 더 복잡한 방법의 계산 오버헤드를 무시할 수 있습니다.

- STR의 저자들은 ImageNet에서 더 나은 결과를 낼 수 있었지만, 우리는 안타깝게도 우리의 실험 설정에서 그것을 복제할 수 없었습니다.

- 가장 주목할 만한 것은 GMP의 글로벌 및 주기적인 선형 학습률 일정과 'Hard' 가지치기 변형을 모두 포함하는 GMP의 변형입니다.

반응형