반응형

Basic Information

- Haotong Qin, Yifu Ding, Mingyuan Zhang, Qinghua YAN, Aishan Liu, Qingqing Dang, Ziwei Liu, Xianglong Liu 저

- ICLR 2022 Accepted

- 논문 아카이브: Link

- 코드 깃헙 링크: Link

서론

- 큰 사전 훈련된 BERT는 자연어 처리(NLP) 작업에서 뛰어난 성능을 보이지만, 계산 및 메모리 소모가 큽니다.

- 이 논문에서는 BERT의 완전한 이진화 (1비트 가중치, 임베딩, 활성화)에 대해 이론적 근거와 경험적 분석을 통해 주요 문제를 파악하고, 이를 해결하기 위한 BiBERT를 제안합니다.

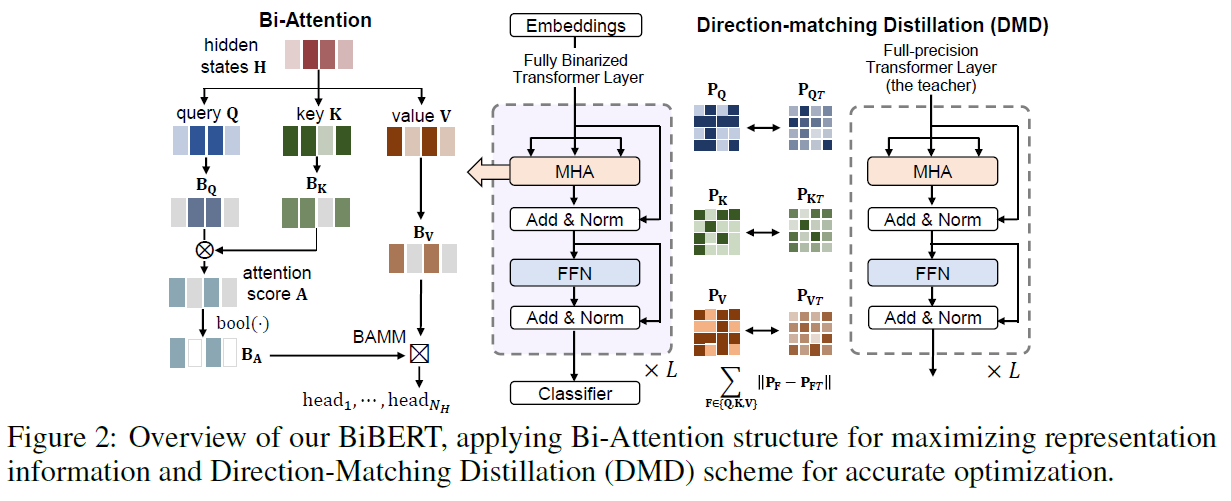

- BiBERT는 표현 정보를 통계적으로 최대화하기 위한 효율적인 Bi-Attention 구조와 완전한 이진화된 BERT를 정확하게 최적화하기 위한 Direction-Matching Distillation (DMD) 체계를 도입합니다.

BiBERT

General

- 이 논문은 위에서 언급한 현상에 대한 경험적 관찰과 이론적 공식을 제공하며, 완전 정밀도 BERT를 강력한 완전 이진화 모델로 변환하기 위한 BiBERT를 제안합니다(Figure 2 참조).

- Attention 메커니즘의 정보 퇴화를 해결하기 위해, 우리는 정보 이론을 기반으로 효율적인 Bi-Attention 구조를 도입합니다.

- Bi-Attention은 최대화된 정보 엔트로피로 이진화된 표현을 적용하여 이진화된 모델이 입력 내용의 인식을 복원할 수 있게 합니다.

- 또한, 우리는 정제 과정에서 방향 불일치를 제거하기 위한 Direction-Matching Distillation (DMD) 체계를 개발했습니다.

- DMD는 적절한 활성화를 취하고 정제 과정에서 구축된 유사성 행렬의 지식을 활용하여 정확하게 최적화합니다.

- 우리의 BiBERT는 처음으로 정확한 완전 이진화 BERT (1비트 가중치, 임베딩, 활성화)를 향한 유망한 경로를 제시합니다.

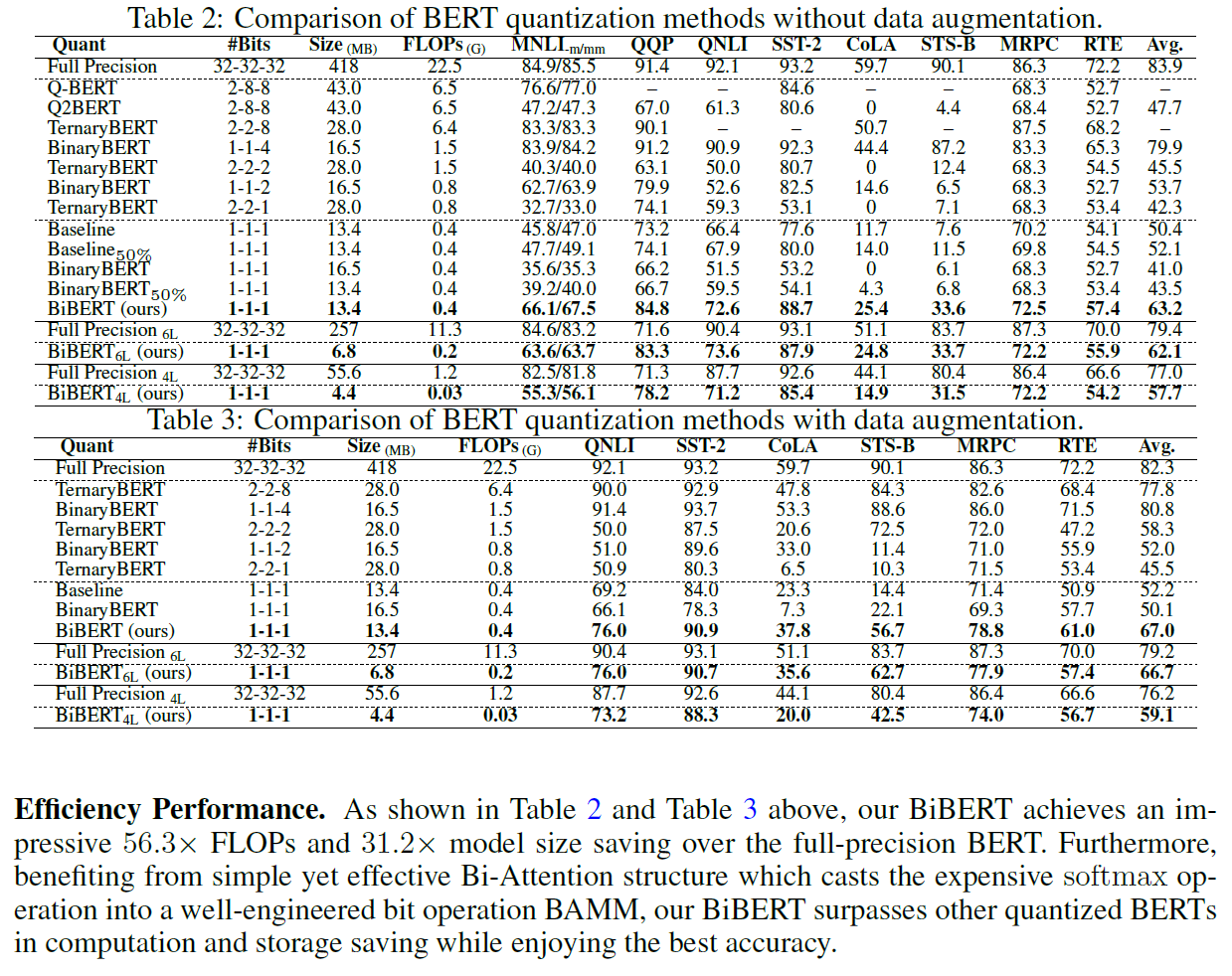

- GLUE (Wang et al., 2018a) 벤치마크에서의 광범위한 실험은 우리의 BiBERT가 초저비트 활성화로 기존 양자화된 BERT 모델을 설득력 있는 여유로움으로 능가한다는 것을 보여줍니다.

- 예를 들어, BiBERT의 평균 정확도는 1-1-1 비트 폭 BinaryBERT (1비트 가중치, 1비트 임베딩 및 1비트 양자화)를 평균 20.4%로 능가하며, 2-8-8 비트 폭 Q2BERT보다 13.3% 더 나습니다.

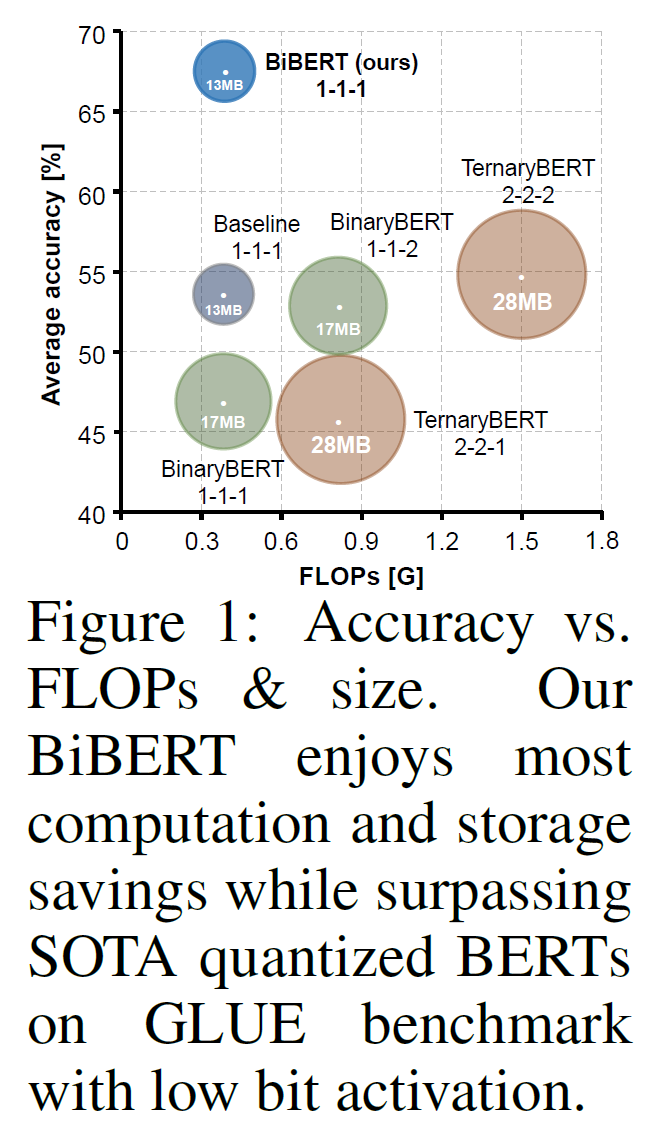

- 또한, 우리의 BiBERT는 FLOPs와 모델 크기에서 각각 56.3배와 31.2배의 인상적인 절약을 제공함으로써, 실제 세계의 자원 제약 시나리오에서 완전 이진화된 BERT 모델의 엄청난 이점과 잠재력을 보여줍니다(Figure 1 참조).

Binarized BERT Architecture

- 이진화된 BERT의 구조에 대해 간략히 소개합니다. 일반적으로, 이진화 네트워크에서의 sign 함수의 순전파와 역전파는 다음과 같이 표현될 수 있습니다:

- 여기에서 C는 미니배치에 대한 비용 함수입니다.

- 순전파에서는 sign 함수가 적용되며, 역전파에서는 straight-through estimator (STE) (Bengio et al., 2013)가 사용되어 미분값을 얻습니다. 이진화 선형 계층의 가중치에 대해서는, 일반적인 관행은 표현 정보를 유지하기 위해 가중치를 제로 평균으로 재분배하고 (Rastegari et al., 2016; Qin et al., 2020), 양자화 오류를 최소화하기 위해 스케일링 인자를 적용하는 것입니다 (Rastegari et al., 2016). 활성화는 계산 효율성을 위해 재스케일링 없이 sign으로 이진화됩니다. 따라서, 계산은 다음과 같이 표현될 수 있습니다:

- 여기에서 W와 X는 각각 전체 정밀도 가중치와 활성화를 나타냅니다.

- 입력 데이터는 변환기 블록(Zhang et al., 2020; Bai et al., 2020)으로 공급되기 전에 이진화 임베딩 계층을 통과합니다. 각 변환기 블록은 두 가지 주요 구성 요소로 구성됩니다: Multi-Head Attention (MHA) 모듈과 Feed-Forward Network (FFN). MHA의 계산은 숨겨진 상태 H에서 파생된 쿼리 Q, 키 K 및 값 V에 따라 달라집니다. N은 시퀀스의 길이를 나타내며, D는 특징의 차원을 나타냅니다. 특정 변환기 계층에 대해, attention head에서의 계산은 다음과 같이 표현될 수 있습니다:

- 여기에서 bi-linearQ, bi-linearK, bi-linearV는 각각 Q, K, V에 대한 세 가지 다른 이진화 선형 계층을 나타냅니다.

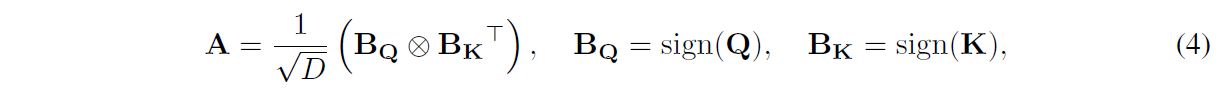

- 그런 다음 attention 점수 A를 다음과 같이 계산합니다:

- 여기에서 BQ와 BK는 각각 이진화된 쿼리와 키를 나타냅니다.

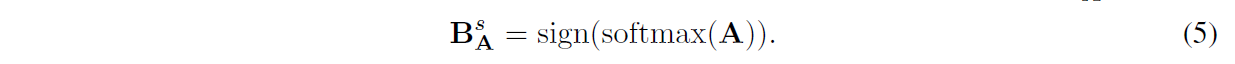

- 주의: 얻어진 attention 가중치는 그런 다음 attention 마스크에 의해 잘립니다, 그리고 A의 각 행은 k-dim 벡터로 간주될 수 있습니다, 여기서 k는 마스크되지 않은 요소의 수입니다. 그런 다음 우리는 attention 가중치 Bs A를 이진화합니다:

- 우리는 이진화 네트워크에서 MHA와 FFN의 나머지를 수행하기 위해 원래 BERT 아키텍처를 따릅니다.

Distillation for Binarized BERT

- Distillation은 양자화된 BERT의 성능 저하를 완화하는 일반적이고 필수적인 최적화 접근법입니다.

- 이는 초저비트 폭 설정에서 어떠한 아키텍처에도 자유롭게 적용될 수 있으며, 전체 정밀도 교사 모델의 지식을 활용합니다 (Jiao et al., 2020; Bai et al., 2020; Zhang et al., 2020; Wang et al., 2020).

- 일반적인 관행은 전체 정밀도 교사 네트워크에서 attention 점수 ATl, MHA 출력 MTl, 그리고 숨겨진 상태 HTl를 계층별로 정제하고, 이진화된 학생 대응물, 즉 Al, Ml, Hl (l = 1, ..., L, 여기서 L은 변환기 계층의 수를 나타냅니다)로 전송하는 것입니다.

- 학생과 교사 네트워크 간의 해당 특징에 대한 차이를 측정하기 위해 평균 제곱 오차 (MSE)를 손실 함수로 사용합니다:

- 그런 다음 prediction-layer distillation Loss는 교사 Logits yT와 학생 Logits y 사이의 Soft Cross-Entropy (SCE)를 최소화함으로써 수행됩니다. 목표 함수는 다음과 같이 표현됩니다:

Full BERT vs BiBERT

실험 결과

추가 분석

Information Performance

- Bi-Attention을 적용함으로써 정보 성능의 향상을 보이기 위해, 기준 모델과 BiBERT에 대한 이진화된 표현의 정보 엔트로피를 비교합니다.

- Figure 6(a)에서 각 모델의 0 계층에서 첫 번째 헤드를 취하며, 모든 헤드와 계층에서 동일한 현상이 존재합니다.

- 훈련 과정 동안 BiBERT의 attention 가중치의 정보 엔트로피는 작은 범위에서 흔들리며 거의 최대화되지만, 기준 모델의 경우 완전히 0으로 저하됩니다.

Training Curves

- 우리는 Figure 6(b)에서 데이터 증가 없이 SST-2에서 완전히 이진화된 BERT 기준 모델과 BiBERT의 훈련 손실 곡선을 그립니다.

- 기준 모델과 비교하여, 우리의 방법은 더 빠른 수렴 속도를 가지며 더 높은 정확도를 달성합니다.

- 이는 정확한 최적화 측면에서 우리의 이점을 제안합니다.

결론

- 우리는 정확한 완전 이진화된 BERT를 향해 BiBERT를 제안합니다.

- 우리는 먼저 완전 이진화된 BERT 기준의 병목 현상을 밝히고 완전 이진화의 영향에 대한 이론적 기반을 구축합니다.

- 그런 다음 BiBERT에서 성능을 향상시키기 위해 Bi-Attention과 DMD를 제안합니다.

- BiBERT는 초저비트 활성화로 기존의 SOTA BERT 양자화 방법을 능가하며, 인상적인 56.3배의 FLOPs와 31.2배의 모델 크기 절약을 제공합니다.

- 우리의 작업은 BERT 완전 이진화의 중요한 문제에 대한 통찰력 있는 분석과 효과적인 해결책을 제공하며, BERT의 극도로 압축된 경로를 제공합니다.

반응형