반응형

Basic Information

- Dachuan Shi, Chaofan Tao, Ying Jin, Zhendong Yang, Chun Yuan, Jiaqi Wang 저

- ICML 2023 Accepted

- 논문 아카이브: Link

- 코드 아카이브: Link (Official Github)

서론

- 대규모 언어 모델의 매개변수와 FLOPs가 최근 몇 년 동안 급증함에 따라, 점점 무거워지는 모델을 엣지 장치에 배포하기 위해 모델 압축이 매우 중요해졌습니다.

- 모델 압축을 위한 여러 접근 방식이 있으며, 이에는 weight sharing, low-rank decomposition, quantization, parameter bootstraping, KD, pruning 등이 포함됩니다.

- 이 논문은 특히 Pruning의 접근 방식에 초점을 맞추고 있으며, 이는 원래 모델의 잘 최적화된 매개변수를 상속받을 뿐만 아니라 다양한 아키텍처에 대한 유연한 설계 공간을 제공합니다.

- 도전 과제: 특히 비전-언어 트랜스포머의 효율적인 압축이 주요 도전 과제로 강조됩니다. 기존의 단일 모달 압축 기술은 이러한 복잡한 모델에 직접 적용하거나 최적화하기 어렵습니다.

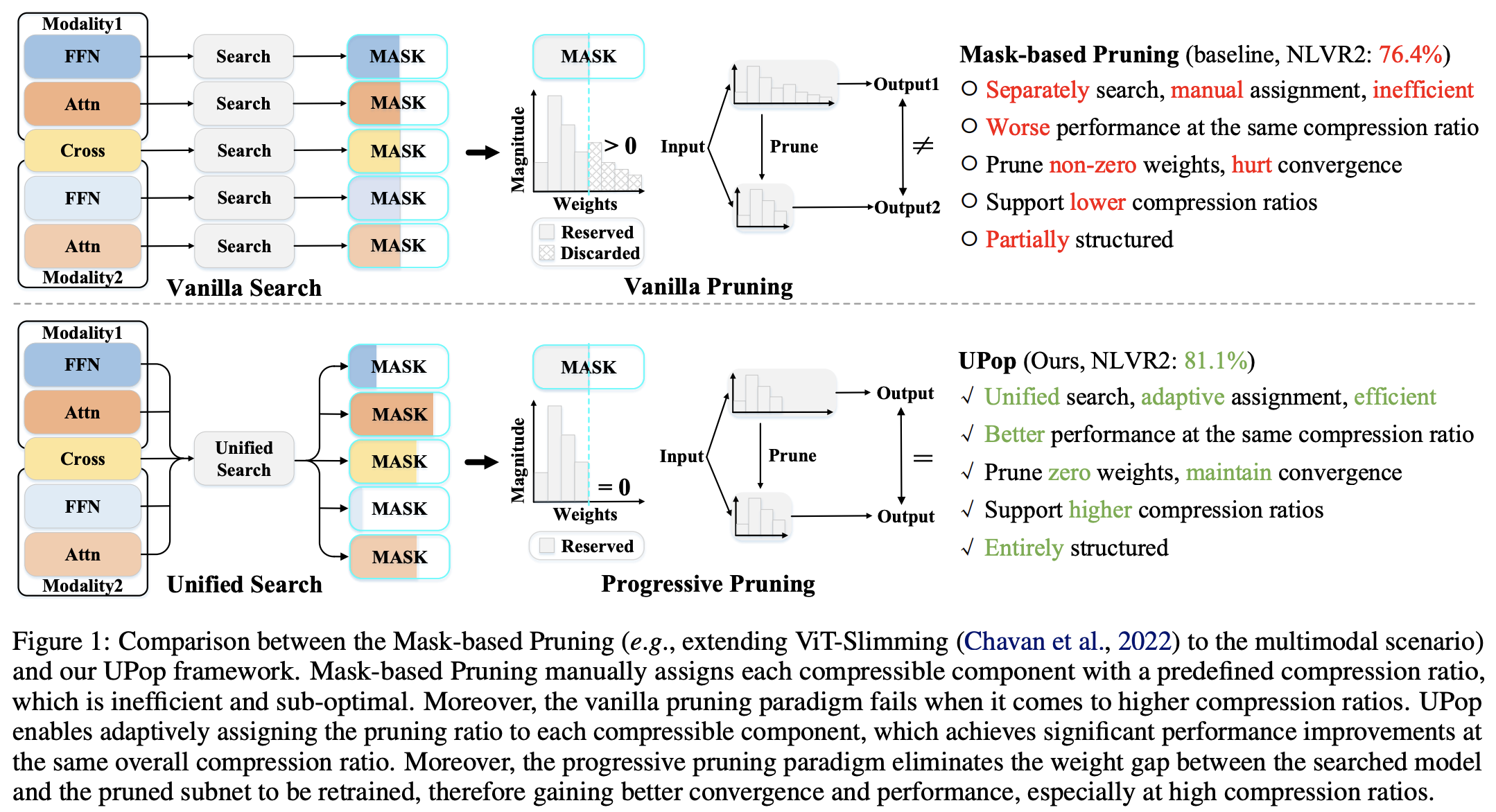

- 제안된 해결책: 저자들은 Unified and Progressive Pruning (UPop)이라는 새로운 다중 모달 프루닝 프레임워크를 소개합니다. 이 프레임워크는 기존 방법의 비효율성을 해결하고 성능 저하 없이 높은 압축 비율을 지원하는 것을 목표로 합니다.

이론적 배경

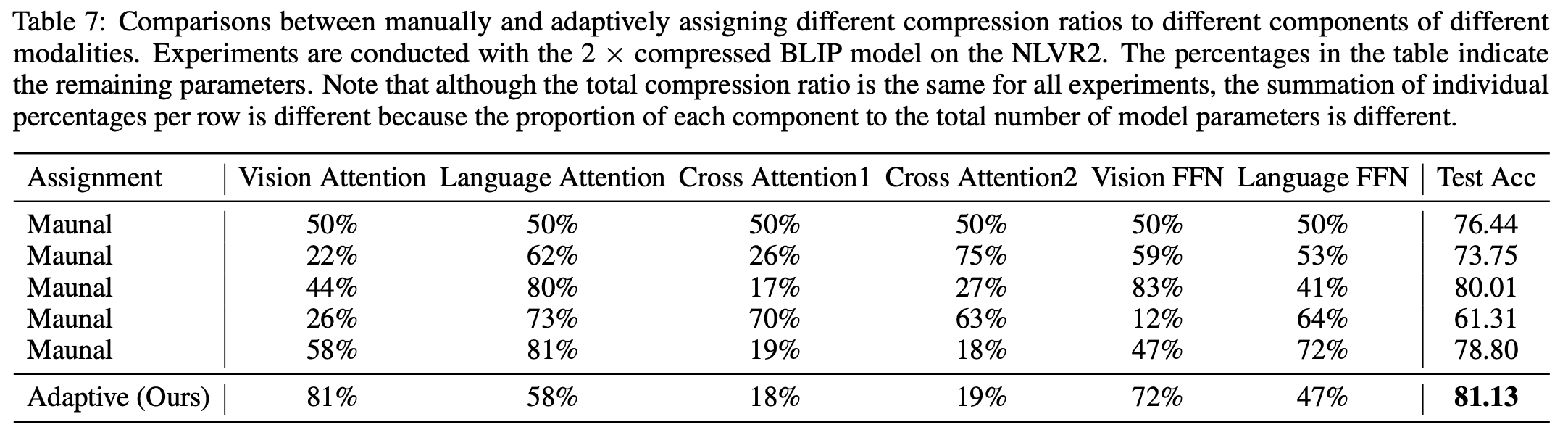

- 다중 모달 프루닝: UPop은 단일 프레임워크 내에서 다른 모달리티(예: 시각과 언어)를 압축하는 도전을 해결합니다. 이는 다양한 구성 요소와 모달리티에 걸쳐 압축 비율을 적응적으로 할당하는 통합 접근 방식을 제안합니다.

- 진보적 프루닝 패러다임: 논문은 높은 압축 비율에서 비효율적인 전통적인 두 단계 프루닝(검색 후 재훈련)을 비판합니다. UPop은 검색과 재훈련이 동시에 이루어지는 진보적 프루닝 방법을 도입하여 더 부드러운 수렴과 더 나은 성능을 가능하게 합니다.

UPop Compression Method

짧은 결과

UPop vs Traditional Method

UPop Framework Overall Flow Architecture

UPop Algorithm

Notation

Algorithm Pseudo Code

실험 결과

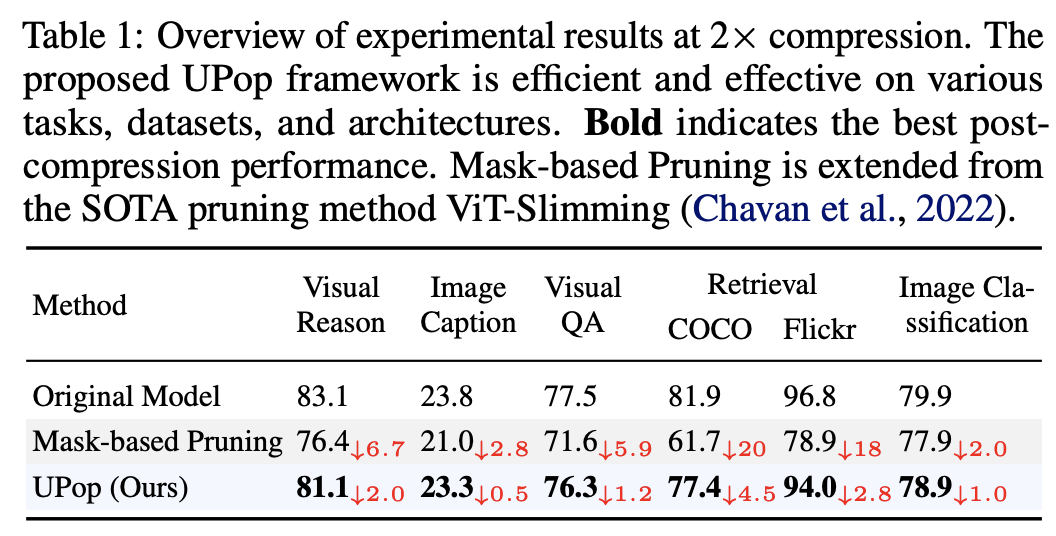

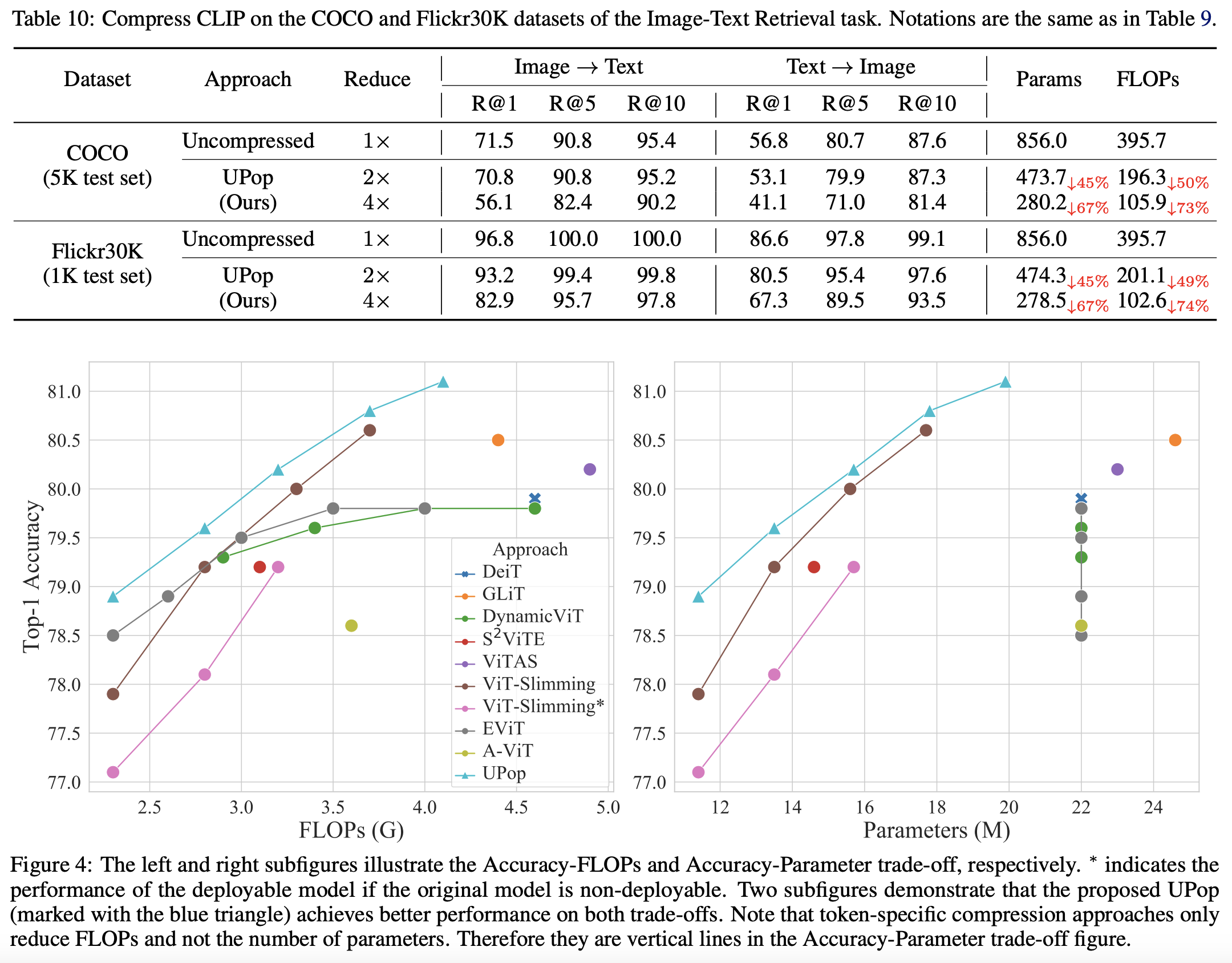

- 효과성과 다양성: UPop의 효과성은 다양한 다중 모달 작업, 데이터셋 및 모델 아키텍처에서 검증됩니다. 이에는 CLIP과 같은 이중 스트림 모델과 BLIP과 같은 혼합 스트림 모델뿐만 아니라 이미지 분류 및 세분화와 같은 단일 모달 작업도 포함됩니다.

- 비교 분석: 결과는 높은 압축 비율에 적응하고 성능을 유지하는 면에서 UPop이 전통적인 방법보다 우수함을 보여줍니다.

결론

- 기여: 이 논문은 비전-언어 트랜스포머를 압축하기 위한 범용 프레임워크를 제공하고, 더 나은 수렴과 더 높은 압축 비율을 지원하는 새로운 프루닝 패러다임을 도입하며, 다양한 작업 및 모델 아키텍처에서 프레임워크의 효과성을 검증하는 것을 주요 기여로 요약합니다.

- 향후 작업: 분석된 섹션에서 명시적으로 언급되지 않았지만, 향후 작업은 UPop 프레임워크를 더욱 정제하고, 다른 유형의 다중 모달 모델에 적용을 탐구하며, 비전-언어 작업을 넘어 다른 도메인으로 그 원칙을 확장하는 것을 포함할 가능성이 높습니다.

반응형