BiBERT: Accurate Fully Binarized BERT

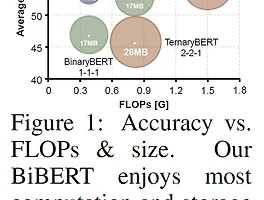

Basic Information Haotong Qin, Yifu Ding, Mingyuan Zhang, Qinghua YAN, Aishan Liu, Qingqing Dang, Ziwei Liu, Xianglong Liu 저 ICLR 2022 Accepted 논문 아카이브: Link 코드 깃헙 링크: Link 서론 큰 사전 훈련된 BERT는 자연어 처리(NLP) 작업에서 뛰어난 성능을 보이지만, 계산 및 메모리 소모가 큽니다. 이 논문에서는 BERT의 완전한 이진화 (1비트 가중치, 임베딩, 활성화)에 대해 이론적 근거와 경험적 분석을 통해 주요 문제를 파악하고, 이를 해결하기 위한 BiBERT를 제안합니다. BiBERT는 표현 정보를 통계적으로 최대화하기 위한 효율적인 Bi-Attention 구조와 완전..

BiBERT: Accurate Fully Binarized BERT

Basic Information Haotong Qin, Yifu Ding, Mingyuan Zhang, Qinghua YAN, Aishan Liu, Qingqing Dang, Ziwei Liu, Xianglong Liu 저 ICLR 2022 Accepted 논문 아카이브: Link 코드 깃헙 링크: Link 서론 큰 사전 훈련된 BERT는 자연어 처리(NLP) 작업에서 뛰어난 성능을 보이지만, 계산 및 메모리 소모가 큽니다. 이 논문에서는 BERT의 완전한 이진화 (1비트 가중치, 임베딩, 활성화)에 대해 이론적 근거와 경험적 분석을 통해 주요 문제를 파악하고, 이를 해결하기 위한 BiBERT를 제안합니다. BiBERT는 표현 정보를 통계적으로 최대화하기 위한 효율적인 Bi-Attention 구조와 완전..